Spotkanie odbyło się 01.06.2020 online poprzez Skype.

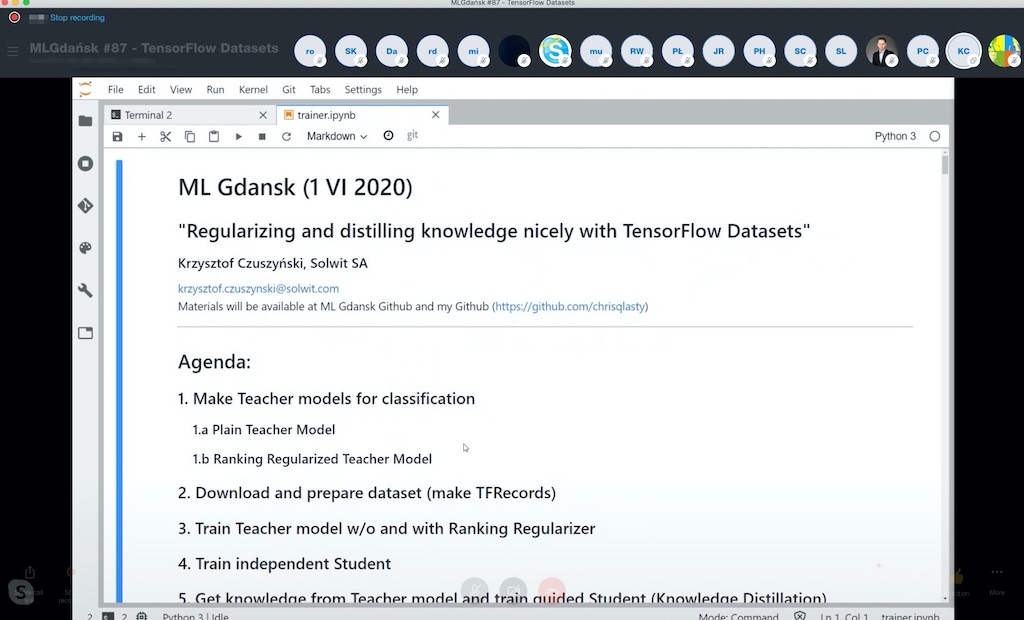

Na spotkaniu wysłuchaliśmy prelekcji Krzysztofa Czuszyńskiego (Solwit) pod tytułem „Regularizing and distilling knowledge nicely with TensorFlow Datasets”.

Prezentacja miała formę szczegółowego omówienia notebooka z implementacją (TensorFlow) dwóch technik poprawiających wyniki działania sieci neuronowych.

Pierwsza z omówionych technik to Ranking Regularizer z użyciem triplet loss w zastosowaniu do zadań klasyfikacji obrazów. Architektura sieci w tym przypadku wymaga dodania kolejnej gałęzi (głowy), która wylicza embeddingi, a wartości funkcji loss z tej gałęzi są używane właśnie do regularyzacji sieci.

Kolejną omówioną przez Krzysztofa techniką było Knowledge Distillation. Jest to podejście do trenowania sieci neuronowych, gdzie „małą sieć” wspomagamy w uczeniu odpowiedziami pochodzącymi z „dużego” modelu.

Materiały ze spotkania – implementacja powyższych technik! – dostępne są na GitHubie:

? https://github.com/mlgdansk/meetings/tree/master/MLGdansk87

Materiały uzupełniające:

- https://arxiv.org/abs/1901.08616 – Boosting Standard Classification Architectures Through a Ranking Regularizer

- https://arxiv.org/abs/1503.02531 – Distilling the Knowledge in a Neural Network

- https://github.com/ahmdtaha/softmax_triplet_loss – implementacja „Softmax + a Ranking Regularizer”

Serdecznie zapraszamy na kolejne spotkania MLGdańsk!