Na 86 spotkaniu MLGdańsk mieliśmy okazję wysłuchać prelekcji Aleksandra Obuchowskiego (SentiOne) pod tytułem „Deep Learning behind chatbots and automatic answering systems„.

W swojej prezentacji Aleksander przedstawił podstawy działania chatbotów. Głównym wątkiem prezentacji był jednak przegląd modeli i techniki stosowanych w różnych zadaniach NLP.

Prezentacja rozpoczęła się od przeglądu klasycznych już metod tworzenia reprezentacji tekstów – CBOW, SkipGram, Fasttext.

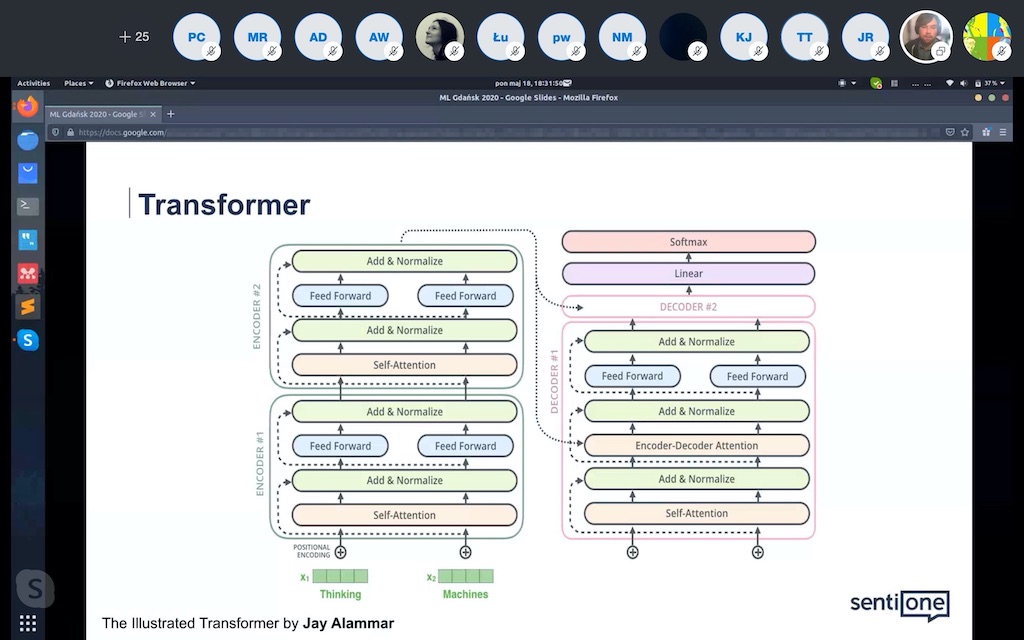

Następnie omówione zostały architektury sieci neuronowych stosowanych w zadaniach NLP – m.in. LSTM, BiLSTM, BiLSTM + CRF (ang. Conditional Random Field). Bardzo interesującą częścią prezentacji było przedstawienie współczesnych architektur bazujących na transformerach oraz mechanizmach atencji.

Aleksander omówił również model oparty na połączeniu transformerów i kapsuł, którego jest współautorem. Model oraz obiecujące wyniki eksperymentów zostały zaprezentowane na 34th AAAI Conference on AI w lutym 2020.

Na sam koniec, prelegent opowiedział nam o metodach pre-trenowania sieci neuronowych w NLP oraz ich późniejszym użyciu. W tej części omówiono modele/biblioteki Flair, ELMO, BERT, USE.

Prezentacja ze spotkania dostępna jest pod linkiem:

MLGdańsk86 – Aleksander Obuchowski – Deep Learning behind chatbots and answering systems

oraz na naszym GitHubie.

Jako uzupełnienie prelekcji polecamy również:

- The Illustrated Transformer

- Contextual String Embeddings for Sequence Labeling

- Transformer-Capsule model for Intent Detection – A. Obuchowski, M.Lew, 2020, Proceedings of the 34th AAAI conference on AI

Serdecznie zapraszamy na kolejne spotkania MLGdańsk!